Prompt Engineering: Was macht ein Prompt Engineer?

Das Ziel von Prompt Engineering ist es, eine Anweisung an ein KI-Modell so zu formulieren, dass es das bestmögliche Ergebnis liefert. Je präziser und strukturierter ein Prompt verfasst ist, desto besser versteht das Modell, was Anwender möchten. Mit dem Prompt Engineer gibt es mittlerweile sogar einen eigenen Berufszweig, der KI-Systeme in Unternehmen implementiert. Wie genau das aussieht, Beispiele und die wichtigsten Guidelines für effiziente Prompts im Überblick.

Was ist Prompt Engineering?

Ein Werkzeug ist immer nur so gut wie sein Bediener. Dieser Leitsatz gilt insbesondere für das Prompt Engineering. Hierbei geht es darum, einen Befehl an ein KI-Modell so zu verfassen, dass es den bestmöglichen Output liefert. So ist die Antwortqualität einer künstlichen Intelligenz maßgeblich davon abhängig, wie präzise die Frage formuliert ist.

LLMs wie ChatGPT, Claude oder Gemini arbeiten mit Wahrscheinlichkeiten. Sie denken nicht wie Menschen, sondern entscheiden bei jedem Wort, welches nächste Wort mit der statistisch höchsten Wahrscheinlichkeit darauf folgt. Dabei nutzen KI-Modelle Milliarden von Texten als Muster. Da sie den Kontext einer Anweisung nicht kennen, antworten sie oft zu allgemein, nicht im gewünschten Format oder an der Zielgruppe vorbei. Prompt Engineers erstellen strukturierte Prompts, indem sie Regeln setzen wie „nenne mir die Antwort in 3 Stichpunkten mit je maximal 50 Wörtern”. Außerdem sorgen sie für Outputs passend zur Zielgruppe, indem sie der KI Rollen vorgeben wie „antworte aus der Sicht eines Wirtschaftsprüfers”. Prompt Engineering bedeutet, präzise, zielgruppengerechte und reproduzierbare Ergebnisse zu erzeugen.

Die Arbeit von Prompt Engineers im beruflichen Umfeld geht dabei weit über das Testen und Optimieren einzelner Prompts hinaus. Sie implementieren KI-Features in bestehende Workflows und Produkte oder schaffen neue KI-basierte Produkte und Tools. Auch beim Vibe Coding, also dem dialogbasierten Programmieren mit der KI, sind präzise Prompts entscheidend für die Qualität des Codes.

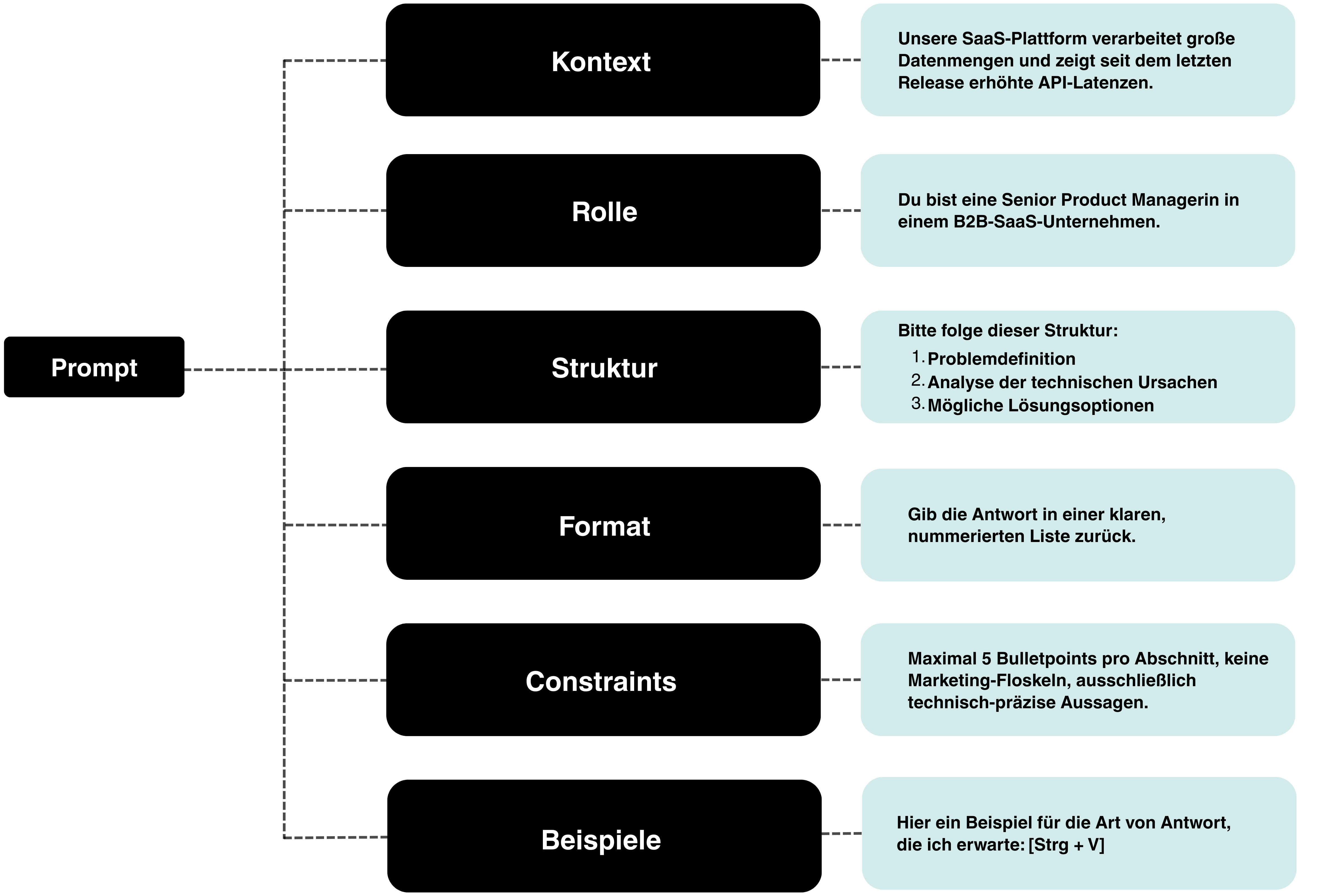

Prompt Engineering Guidelines

Beim Prompt Engineering gilt: Input gleich Output. Eine gute Arbeitsanweisung an die KI spart nicht nur Frust, sondern auch unnötige Feedback-Schleifen. Dabei helfen folgende Guidelines:

Klare Rollen vergeben

KI-Modelle tendieren zu allgemeingültigen, oberflächlichen Antworten, die oft die fachliche Tiefe vermissen lassen. Dem lässt sich gegenlenken durch das Vorgeben klarer Rollen wie: „Du bist Fachanwalt für Wirtschaftsrecht” oder „Du bist Senior Product Manager”.

Auch weitere Informationen zum Kontext wie die Branche, das Ziel, Tone of Voice oder Zielplattformen wie Web oder Print helfen, die Antwortqualität zu steigern.

Struktur vorgeben

LLMs lieben Struktur. Deshalb ist es wichtig, einen klaren Rahmen zu schaffen, wie zum Beispiel: „Antworte in Tabellenform”. Auch eine klare Gliederung ist hilfreich: „Nutze diese Struktur: 1. Problem 2. Lösung 3. Beispiel 4. Fazit".

Format definieren

Falls ein bestimmtes Format benötigt wird wie CSV, JSON oder HTML, sollten Anwender:innen das von vornherein mitteilen.

Beispiele nennen

Beim sogenannten Few-Shot-Prompting geben Prompt Engineers dem KI-Modell mehrere Beispiele als Muster vor: „Hier ist ein Beispiel für das gewünschte Format. Bitte erstelle 10 weitere Beispiele nach demselben Muster.“

Constraints festlegen

Hilfreich ist es auch, dem LLM feste Grenzen zu setzen wie eine Zeichenbegrenzung oder konkrete Vorgaben wie „keine Verwendung werberischer Adjektive”. Eine gute Möglichkeit besteht darin, klare Do- und Don’t-Listen zu erstellen.

Komplexe Aufgaben in Schritte zerlegen

Gerade bei großen Aufgaben hilft es, diese in einzelne Arbeitsschritte aufteilen. Beispiel: „1. Analysiere das Problem. 2. Erstelle eine Struktur. 3. "Generiere den Inhalt auf Basis der zuvor erstellten Struktur.“

Den Umgang mit Unsicherheiten erzwingen

Wenn LLMs unsicher sind, halluzinieren sie. Das bedeutet: Bevor sie keine Antwort liefern, denken sie sich etwas aus. Um das zu verhindern, ist es sinnvoll, dem KI-Modell klare Vorgaben im Hinblick auf Unsicherheiten zu geben: „Wenn dir keine verlässlichen Informationen vorliegen, schreibe: ‚Dazu liegen mir keine gesicherten Informationen vor.‘“

Zusätzlich macht es Sinn, die Antwort von der KI mit Quellen belegen zu lassen. Diese sollten unbedingt geprüft werden, da es auch hier zu Halluzinationen kommen kann.

Techniken und Arten von Prompts

Neben den zuvor genannten allgemeinen Guidelines, gibt es je nach gewünschten Output verschiedene Prompt-Techniken. Damit lässt sich die Genauigkeit der Antwort gezielt steuern. Hier ein Überblick über die häufigsten Techniken im Prompt Engineering:

Zero-Shot-Prompting

Dabei handelt es sich um die einfachste Form des Prompts, bei dem die Anweisung oder Frage an die KI ohne zusätzlichen Kontext formuliert wird.

Die Unvoreingenommenheit des KI-Models kann bei einigen Arbeitsanweisungen wie einem kreativen Brainstorming durchaus gewollt sein. Auch bei der Zusammenfassung oder Übersetzung eines Textes ist die Einordnung in einen Kontext oft nicht erforderlich.

One-, Few- und Multi-Shot-Prompts

Dabei geben Anwender:innen der KI ein oder mehrere Beispiele für den gewünschten Output vor, bevor sie ihren eigentlichen Prompt eingeben. Basierend auf diesen Beispielantworten ist das LLM dazu in der Lage, besser zu verstehen, welche Antwort Anwender:innen wünschen. Diese Technik ist besonders effizient für Tonalität und Stilvorgaben, ebenso wie für die Struktur beispielsweise von Tabellen und Texten.

Persona- oder Role-Prompts

Dabei versetzen Prompt Engineers das KI-Modell in eine bestimmte Rolle. Sie geben vor, dass das LLM beispielsweise als Product Owner, Senior Developer oder Wirtschaftsexperte antworten soll. Role-Prompts machen vor allem dann Sinn, wenn Perspektive, Zielgruppe oder Expertise eine Rolle spielen.

Chain-of-Thought (CoT)

Dabei handelt es sich um eine Prompt Engineering Technik, bei der Anwender:innen einen Denkpfad erzwingen. Ziel ist es, dass das KI-Modell nicht eine finale Antwort ausgibt, sondern seinen Denkprozess dokumentiert.

Diese Form des Promptings macht beispielsweise bei strategischen Entscheidungen Sinn. Dabei zählt nicht nur das Ergebnis, sondern vor allem auch der Weg dorthin sowie eine nachvollziehbare Argumentationslinie. Produktmanager beispielsweise können diesen Denkweg in ihren Decision-Log übernehmen.

Beispiel für einen Chain-of-Thought-Prompt: „Denke Schritt für Schritt: Unser Server verbraucht seit dem letzten Deployment deutlich mehr RAM. Was sind die zwei wahrscheinlichsten technischen Gründe? Was sollten wir zuerst prüfen?“ Dabei kann es durchaus auch Sinn machen, die KI mehrere Rollouts zur gleichen Frage ausführen zu lassen. So lässt sich überprüfen, ob die Antwort sehr zuverlässig ist oder die KI bei der gleichen oder ähnlichen Frage zu verschiedenen Resultaten kommt.

Tree-of-Thought (ToT)

Dabei handelt es sich um eine komplexere Form des Chain-of-Thought-Prompts. Dabei denkt die KI nicht linear, sondern erzeugt mehrere mögliche Lösungswege. Diese Lösungswege bewertet sie, verwirft schlechte Pfade und wählt letztendlich die plausibelsten Lösungsansätze.

Beispiel: „Denke in mehreren Lösungswegen: Unsere Python-App wird unter Last instabil. Erzeuge drei alternative Erklärungen, bewerte sie kurz und entscheide, welche am wahrscheinlichsten ist.“

Contrastive Prompting

KI-Modelle neigen dazu, den Konsens wiederzugeben. Bei einigen Fragen kann es Sinn machen, das Modell zur Differenzierung zu zwingen wie: „Gib mir eine riskante und eine konservative Lösung.“

Red-Teaming-Prompt

Dabei weisen Prompt Engineers das LLM dazu an, die eigene Antwort zu hinterfragen. Dadurch lassen sich mögliche Schwachstellen identifizieren.

Expansion Prompting

Diese Technik lässt sich beispielsweise zum Brainstormen in der Produktentwicklung einsetzen. So weisen Anwender:innen ein LLM dazu an, eine Idee zu erweitern und in mehrere Richtungen zu denken.

Meta Prompting

Dabei verbessert die KI zunächst den Prompt selbst, bevor sie ein Ergebnis liefert. Ziel ist es, eine strukturierte, wiederverwendbare Denkvorlage zu erzeugen, die sich für ähnliche Problemstellungen nutzen lässt.

Gehalt: Was verdient ein Prompt Engineer?

Das Berufsbild des Prompt Engineers ist vergleichsweise jung, weshalb es hier noch keine verlässlichen Gehaltsstatistiken gibt. Hinzu kommt, dass die Auslegung des Rollenprofils je nach Unternehmen sehr unterschiedlich ausgestaltet sein kann.

Aufgrund der rasant wachsenden Nachfrage nach Spezialisten im Bereich der künstlichen Intelligenz ist jedoch davon auszugehen, dass übliche Gehälter deutlich über dem bundesweiten Durchschnitt liegen. Eine Orientierung für mögliche Gehälter bieten vergleichbare Berufe wie die des AI Software Engineers mit einem Jahresgehalt zwischen 70.000 und mehr als 100.000 Euro.

Wege ins Prompt Engineering

Einen vorgegebenen formalen Bildungsweg ins Product Engineering in Form eines Studiums oder einer Ausbildung gibt es nicht. Berufseinsteiger stammen häufig aus angrenzenden Tech-Berufen wie dem Produktmanagement, UX/UI-Design oder der Softwareentwicklung. Eine gute Möglichkeit, sich mit den erforderlichen Grundlagen vertraut zu machen, besteht in spezialisierten Weiterbildungen wie unserem AI Bootcamp für Software Engineers.